英伟达继续发力,黄教主引领AI领域,横扫世界舞台!

摘要:他还对汽车业进行了预测:“(未来)整个工厂都将是软件定义的机器人,他们制造的汽车本身也将是机器人。这意味着,机器人设计的机器人去制造机器人。”

北京时间8月8日晚,英伟达NVADIA创始人、CEO黄仁勋在美国洛杉矶的 SIGGRAPH(计算机图形大会)2023现场向数千名观众发表了主题演讲,并通过直播分享给全球观众。

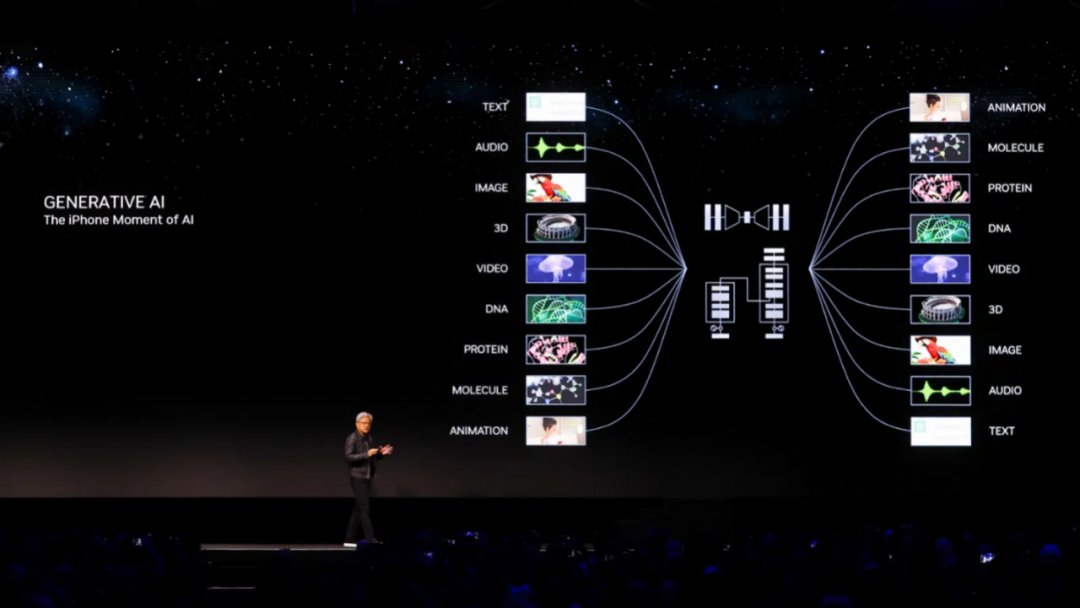

“生成式AI时代和AI的iPhone时刻已经到来”,黄仁勋强调。

随着ChatGPT引发AI大模型需求热潮,占全球80%以上的GPU服务器市场份额和全球91.4%的企业GPU市场份额的英伟达NVIDIA,近三个月内股价涨幅就达56%,今年以来股价累计涨幅已超过210%,过去7年股价增长超40倍,目前市值冲破1.1万亿美元。

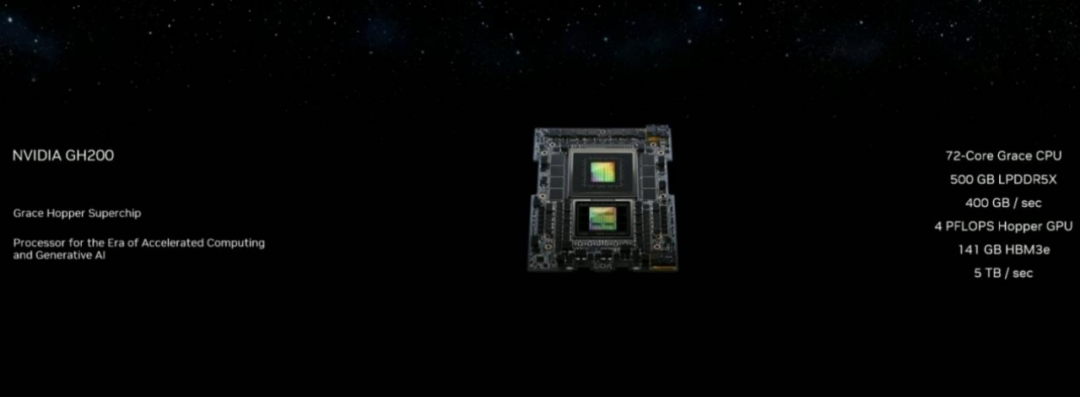

演讲中,黄仁勋发布了GH200 Grace Hopper 超级芯片和名为NVIDIA AI Workbench的全新统一工作空间,以简化NVIDIA AI平台上模型的调节和部署。此外,他宣布将对NVIDIA Omniverse进行重大升级,加入对生成式AI和 OpenUSD的支持。

黄仁勋表示:“计算机图形学和 AI 密不可分,图形学需要 AI,AI 也需要图形学。”他解释说,AI 将在虚拟世界中学习技能,于此同时,AI 也可以用于创建虚拟世界。

这些发布旨在将过去十年所有的创新结合在一起,其中包括人工智能、虚拟世界、加速、模拟、协作等创新与技术。

演讲过程中,黄仁勋有句口头禅:“More you buy, more you save(你买得越多,越省钱)”。

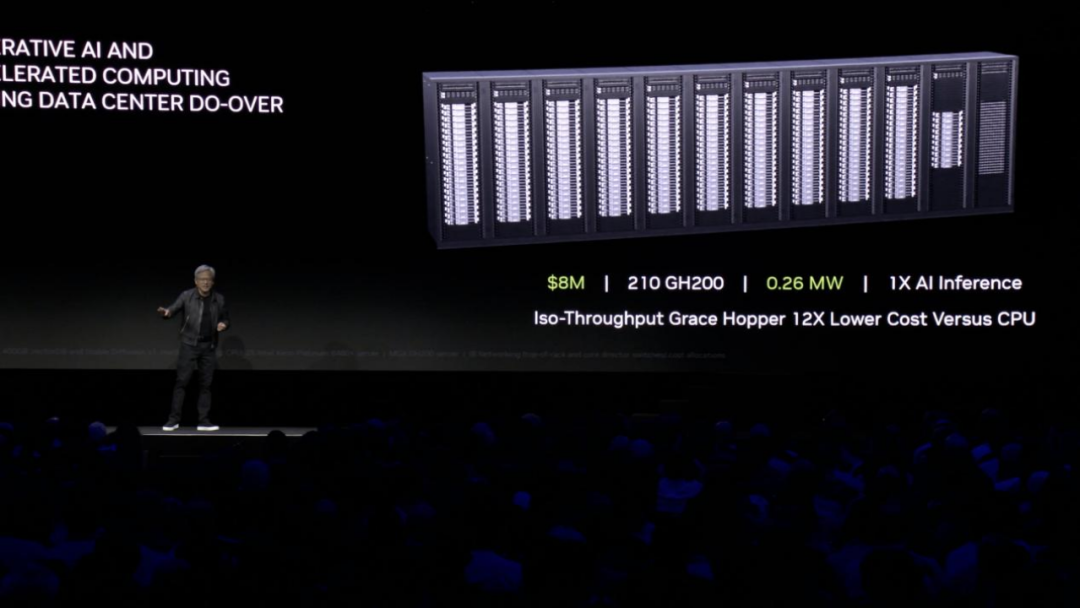

具体体现在新款超级芯片GH200上,他表示,花1亿美元购买8800片x86 CPU实现的AI计算性能,只花800万美元购买210片GH200就能实现,而能耗也将由5MW降至0.26MW。也就是说,实现同样的性能,购买GH200只要花费不到1/12的价格,近1/20的能耗。如此算来,可不真是买得越多,省得越多嘛。

新一代超级芯片:生成式AI的基础

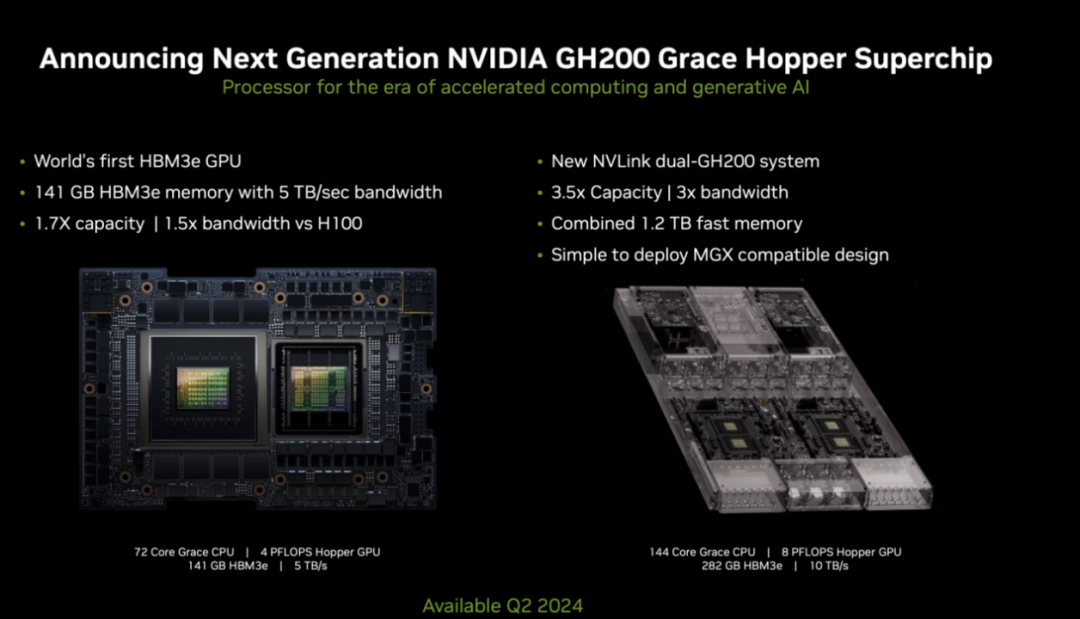

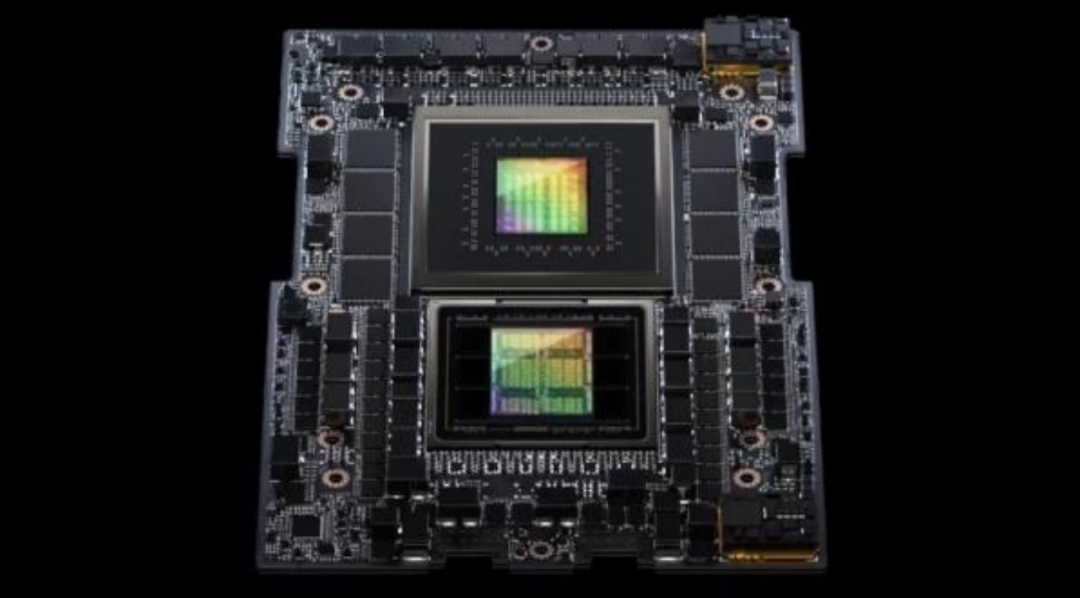

NVIDIA这次推出最硬核的产品是强化版的GH200 Grace Hopper 超级芯片,先前发表的GH200 Grace Hopper 超级芯片,结合了 72 核 Grace CPU 和 Hopper GPU,已经于 5 月投产。

NVIDIA创始人、CEO黃仁勋在SIGGRAPH 2023上展示GH200 Grace Hopper 超级芯片▼

新款 GH200 Grace Hopper 超级芯片将Hopper架构GPU和Arm架构Grace CPU结合,拥有72个Arm v9架构CPU内核,16896个FP32 CUDA GPU内核,搭配 141 GB HBM3e 内存,对比目前版本的GH200,不仅内存速度提升50%,带宽升至每秒5TB,内存容量也暴增近50%。相比最热门的H100芯片,其内存增加1.7倍,带宽增加1.5倍。

配备HBM3e 内存的 GH200 Grace Hopper 超级芯片正在样品测试中,预计将于 2024 年第二季度上市。

现场还展示了一具有 144 个 Arm Neoverse 核心、8 petaflops AI 性能和 282 GB 最新 HBM3e 内存的单服务器DGX GH200。预计将在 2024 年第二季度交付。

黄仁勋表示,这是专为处理世界上复杂的生成式工作负载而构建的新计算平台,将提供多种配置,其中涵盖大型语言模型、推荐系统和矢量数据库等。与前一代产品相比,它不但提供更高的带宽与传输速度,容量也有所提升,对于AI运算来说有相当大的帮助。

英伟达负责超大规模和高性能计算的副总裁伊恩·巴克(Ian Buck)表示,新版本的Grace Hopper超级芯片提高了高带宽内存的容量,这将使该设计能够支持更大的人工智能模型。该配置经过优化,可执行人工智能推理功能,有效地为ChatGPT等生成式人工智能应用程序提供动力。

AI Workbench平台:加速自定义生成式AI的应用

为了加快全球企业对自定义生成式AI的应用,黄仁勋发布了NVIDIA AI Workbench。该平台为开发者提供了一个统一、易用的工作空间,使他们能够在个人电脑或工作站上快速创建、测试和微调生成式AI模型,然后将这些模型扩展到几乎所有数据中心、公有云或 NVIDIA DGX Cloud。

AI Workbench 大大降低了企业AI项目的门槛。开发者通过在本地系统上运行的简单界面,就可以使用自定义数据对来自 Hugging Face、GitHub 和 NGC 等常见资源库的模型进行微调,然后在多个平台上轻松共享。

NVIDIA 创始人兼首席执行官黄仁勋在SIGGRAPH 主题演讲的现场,座无虚席▼

借助AI Workbench,开发者只需点击几下就能自定义和运行生成式AI。开发者可以将所有必要的企业级模型、框架、SDK 和库整合到一个统一的开发者工作空间中。

“有了AI Workbench,任何人都可以做到这些。”黄仁勋说道。

黄仁勋还宣布NVIDIA将与初创企业Hugging Face一起为数百万开发者提供生成式AI超级计算,帮助他们构建大型语言模型等高级AI应用。

开发者将能够使用Hugging Face 平台内的NVIDIA DGX Cloud AI 超级计算训练和调整高级 AI 模型。

黄仁勋表示,“这将是一项全新的服务,将世界上顶尖的AI社区与顶尖的训练和基础设施连接起来。”

最终,通过 AI Workbench,客户可以将新模型部署到企业应用程序中。

Omniverse平台重大升级:支持生成式AI

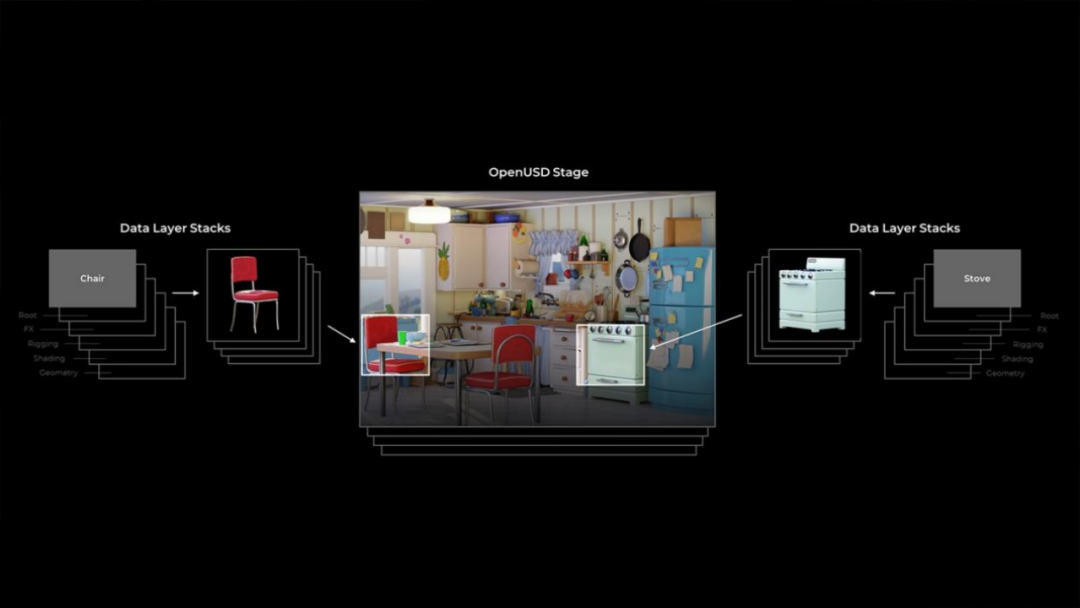

Omniverse 计算机图形与仿真模拟平台是英伟达 OpenUSD 原生软件平台,用于跨工具构建、模拟和协作,为开发人员和企业提供新的基础应用程序和服务。Cesium、Convai、Move AI、SideFX Houdini 和 Wonder Dynamics 现已通过 OpenUSD 连接到 Omniverse。

黄仁勋在演讲中发布了 NVIDIA Omniverse 的重要更新,加入对生成式AI和 OpenUSD的支持以实现工业数字化。主要亮点包括 Omniverse Kit(用于开发本地 OpenUSD 应用程序和扩展的引擎)以及 NVIDIA Omniverse Audio2Face 基础应用程序和空间计算功能的改进。其他改进包括新的模块化应用程序构建、新的开发者模板和资源,以及提高效率和用户体验。

NVIDIA Omniverse和模拟技术副总裁 Rev Lebaredian 表示:“工业企业正在竞相将其工作流程数字化,增加了对支持 OpenUSD 的连接、可互操作3D 软件生态系统的需求。最新的 Omniverse 更新允许开发者通过 OpenUSD 利用生成 AI 来增强他们的工具,允许企业构建更大更复杂的空间规模模拟作为其工业应用的数字测试场。”

包括对话式AI角色创建工具Convai、高保真AI动捕工具Move AI、AI低成本制作CG工具CGWonder Dynamics在内,一系列流行AI工具,现在都已经通过OpenUSD集成到Omniverse中。Adobe也计划将Adobe Firefly作为API,集成在Omniverse中。

黄仁勋在演讲中对未来AI行业的发展做了大胆的展望:“大型语言模型是一个新的计算平台,人类(语言)是新的编程语言。我们已经使计算机科学民主化,每个人都可以成为程序员。”

他还对汽车业进行了预测:“(未来)整个工厂都将是软件定义的机器人,他们制造的汽车本身也将是机器人。这意味着,机器人设计的机器人去制造机器人。”

直播中

2024款坦克300上市直播发布会

广告重点推荐

广告重点推荐

美国Uber打车,生意这么火爆吗?

通用自动驾驶取得里程碑式的新进展

主打五座大空间,哪吒AYA上市售价7.38万元起

被这群“小狐狸”暖到了,极狐车友爱心物资车队驰援房山灾区

责任编辑:苏城

网友评论